Chiacchiera

ieri alle ore 17:53 - 3.060 visualizzazioni

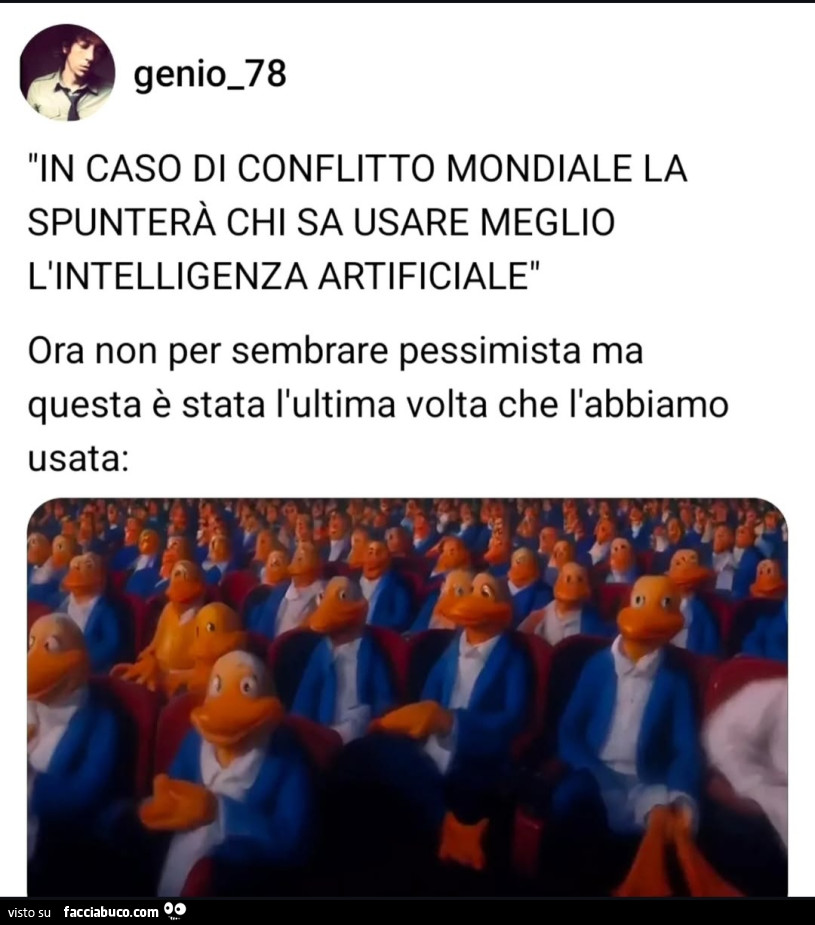

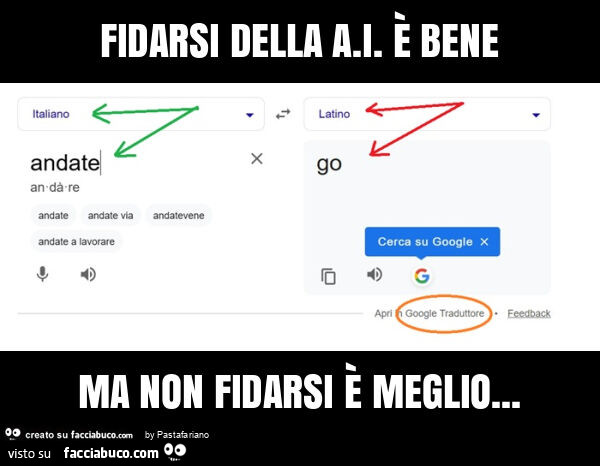

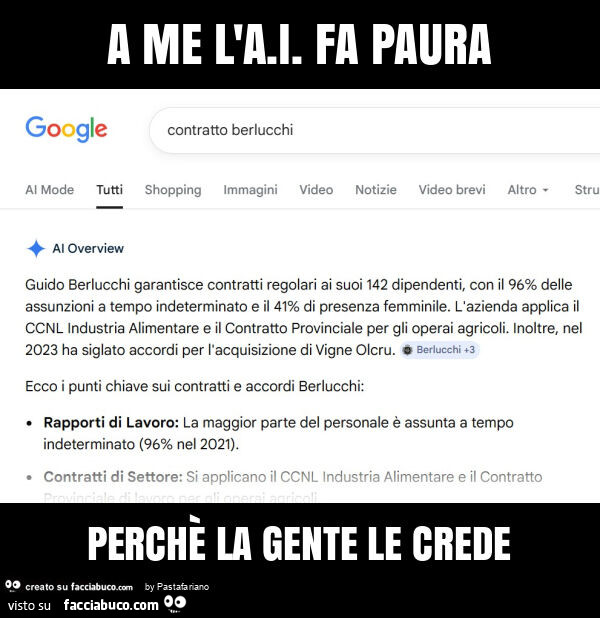

Cercavo solo l'Aperitivo di fine secolo e invece... 😶

Dessi: Anche a me.

1

ieri alle ore 18:01 · Ti stimo · Rispondi

KalimerA: Dessi idem ...

2

ieri alle ore 22:33 · Ti stimo · Rispondi

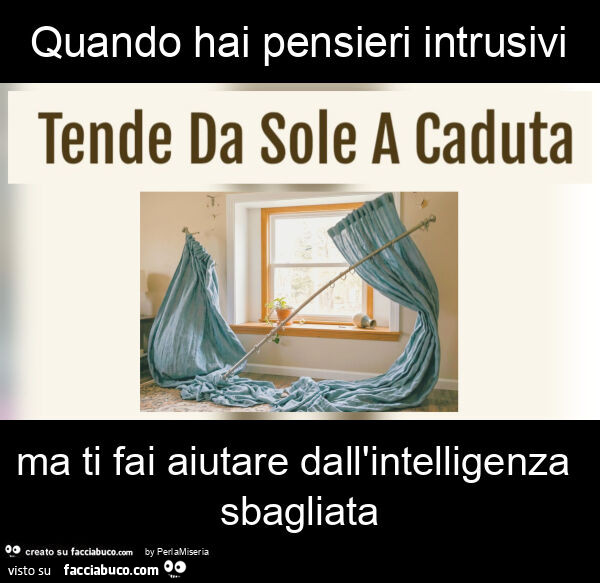

Dessi: KalimerA io volutamente l'ho ignorata, pur essendo appassionato di computer fin dal Commodore 64.... figurati.

ieri alle ore 22:35 · Ti stimo · Rispondi